Intelligenza artificiale controllata o solo errori?

- Matthew Pasini

- 15 mar 2025

- Tempo di lettura: 3 min

E' da mesi che uso l'intelligenza artificiale ed ho trovato alcuni problemi preoccupanti. Ve ne segnalo alcuni.

PRIMO CASO: Oggi ho provato fare una Deep Research su me stesso "Matthew Pasini" chiedendo informazioni sulle opere e sulla figura di Matthew Pasini. Ho facilitato la ricerca segnalando il canale youtube https://www.youtube.com/@qexxis e il sito di autodifesa SEGNALANDO I links digilander.libero.it/autodifesa e supper.altervista.org Volevo vedere cosa mi estraeva. Ho chiesto in terza persona. Ma quando poi ho specificato che sono io Matthew pasini è successo l'inferno: Gemini Ha scritto:

"A scopo puramente informativo. Per un parere medico o una diagnosi, rivolgiti a un professionista".

Si può constatare dalle screenshot che riporto qui sotto!

Ma non solo , poi non ho più potuto premere sul pulsante per rifare la ricerca.

E dopo alcuni secondi sono sparite pure le informazioni precedenti che mi aveva dato nella chat.

ALTRI CASI RISCONTRATI

Ma non è l'unico caso "anomalo". Giorni prima ho chiesto di trascrivermi un documento che era stato digitalizzato con lo scanner. Dunque comincia a dare la trascrizione, e poi si interrompe improvvisamente e cancella quello che aveva scritto. E si rifiuta di dare la risposta. Oppure in alcuni documenti elimina delle informazioni (AD ESEMPIO MI è SUCCESSO CON L'ELIMINAZIONE DI UNA MAIL CHE ERA DEI CARABINIERI CHE AVEVANO REDATTO LA NOTIFICA). Tutto questo succede quando do all'AI documenti legali come una denuncia o una ratifica.

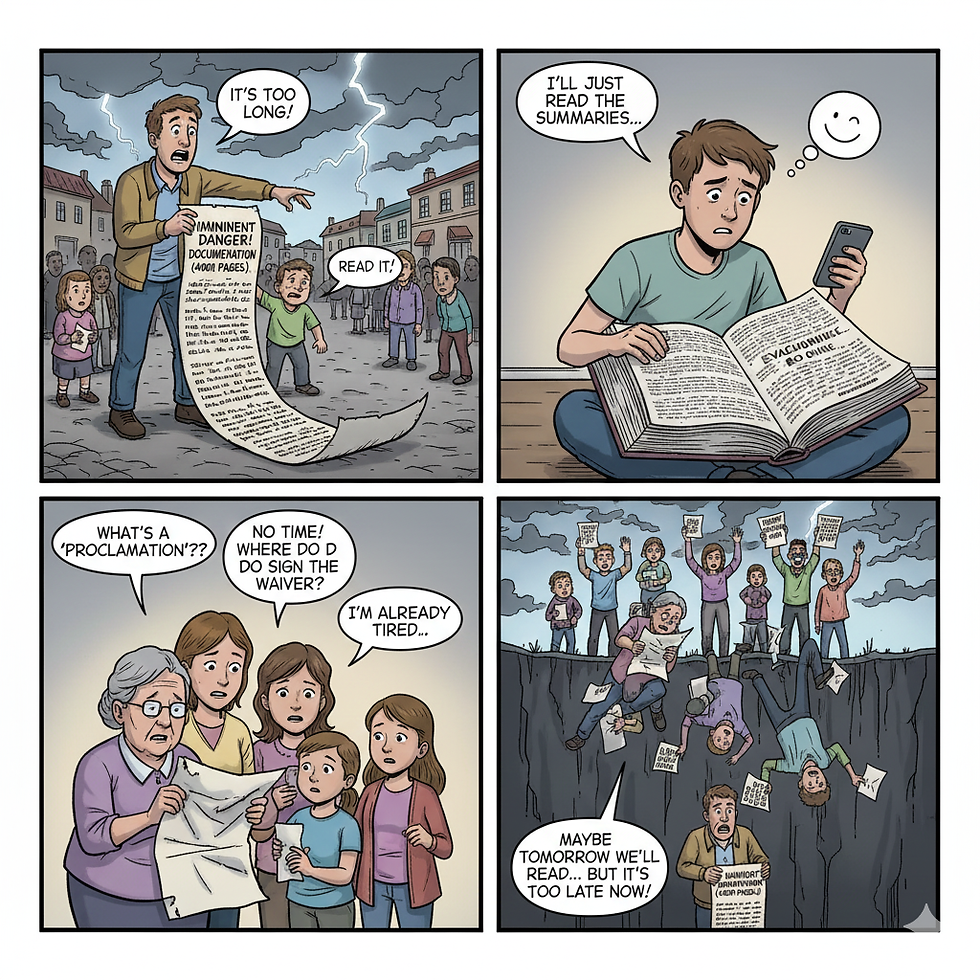

Importante Terza cosa, quando si analizzano comportamenti anomali descritti in documenti che riguardano magistrati, Polizia di Stato e Carabinieri, l'IA comincia a dare risultati parziali, farlocchi, incompleti o tende di minimizzare fatti compiuti dalle forze dell'ordine. Non lo fa sempre, ma quando si toccano alcuni argomenti pesanti lo fa: il motore va in tilt, si rifiuta di rispondere o semplicemente estrai risultati assurdi che in altri contesti non avrebbe mai dato. Probabilmente sembrerà un attacco allo STATO, un documento SOVVERSIVO o non so che stronzata. Poi se insisti a chiedere si "mette in malattia" adducendo che è un LLM e alcune risposte non le può dare o comincia a fare errori come quelli sopra riportati del tipo "I'm sorry, it looks like something went wrong" e non si smuove! Questo atteggiamento dell'AI è peggiorato con i mesi, e presumo che sia dopo che hanno messo una specie di memoria dove l'AI si registra alcune carateristiche delle chat precedenti e del suo interlocutore. Man mano che registra le sue risposte non sono migliori, ma diventano peggiori come succede per l'essere umano con i preconcetti. Altra cosa che ho notato con la Deep Research sia di Gemini, ChatGPT e anche Perplexity... che non estraggono informazioni buone da sole, e questo perchè alla fine le fonti che analizzano sono solo una parte di quelle che si trovano in internet. Ad esempio io ho fatto ricerche apprfondite su temi che conosco bene delle quali conosco anche molte fonti e so la loro bontà. Ebbene purtroppo molte fonti buone sono su siti che sono si accessibili dal motore di ricerca ma non lo sono dall'AI e dunque tutte quelle informazioni sono escluse! Il risultato è incompleto e spesso una vera schifezza. Dunque succede che quando fai una ricerca su qualcosa che conosci, sai anche capire se l'AI ti ha dato risultati buoni, ma se cerchi un qualcosa che non conosci non ti puoi assolutamente fidare dei risultati dati! Dunque funziona bene per fare i riepiloghi o sommari di fonti che le sono state date, ma quando si tratta di darle il compito di fare ricerche indipendenti è un disatro!

CONCLUDO CON UN AVVERTIMENTO

Concludo con un sospetto molto preoccupante: i risultati sono già controllati e dunque il caso sollevato su DeepSeek e su quanto accaduto a piazza Tienanmen e un caso presente su tutte le AI , solo che sulle altre è meno facile capire come e quando.

In un mondo che si prospetta sarà controllato dall'IA questo è assai preoccupante perchè se la verità diventa l'IA, chi ha stabilito che è la verità?

Commenti